栏目分类九游会体育复杂性主要体当前两个方面: EP引入跨节点的传输-九游会·(j9)官方网站

你的位置:九游会·(j9)官方网站 > 新闻 >九游会体育复杂性主要体当前两个方面: EP引入跨节点的传输-九游会·(j9)官方网站

发布日期:2025-03-11 01:31 点击次数:173

专题:DeepSeek为何能挪动全球AI圈

【导读】DeepSeek一天能赚些许钱?官方一霎揭秘!潞晨科技暂停DeepSeek API干事

中国基金报记者 泰勒

环球好,一谈温雅一下对于DeepSeek的最新音问!

DeepSeek初度清晰:表面本钱利润率545%

当市集合计DeepSeek的开源周内容发布完了之后,3月1日,DeepSeek晓谕了“One More Thing”,一霎揭秘V3/R1推理系統,公开了大领域部署本钱和收益。

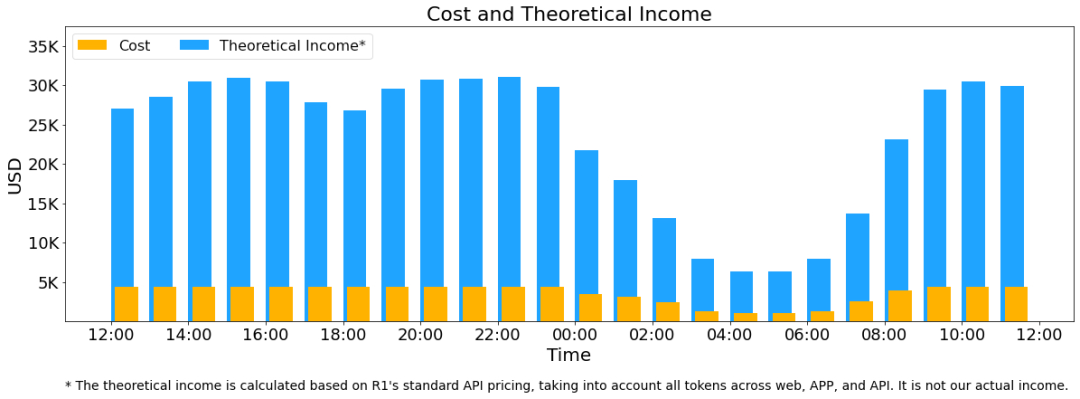

凭据《DeepSeek-V3/R1推理系统概览》的著作,假设GPU租出本钱为2好意思元/小时,总本钱为87072好意思元/天;淌若扫数tokens全部按照DeepSeek R1的订价诡计,表面上一天的总收入为562027好意思元/天,本钱利润率为545%。

据官方清晰,DeepSeek-V3/R1推理系统的优化策画是:更大的糊涂,更低的蔓延。

为了杀青这两个策画,DeepSeek使用大领域跨节点内行并行(Expert Parallelism / EP)。领先EP使得batch size大大增多,从而擢升GPU矩阵乘法的遵守,擢升糊涂。其次EP使得内行分散在不同的GPU上,每个 GPU 只需要诡计很少的内行(因此更少的访存需求),从而缩小蔓延。

但EP同期也增多了系统的复杂性。复杂性主要体当前两个方面:

EP引入跨节点的传输。为了优化糊涂,需要想象相宜的诡计过程使得传输和诡计不错同步进行。

EP波及多个节点,因此自然需要Data Parallelism(DP),不同的DP之间需要进行负载平衡。

因此,DeepSeek先容了奈何使用EP增大batch size,奈何遮拦传输的耗时,奈何进行负载平衡。

大领域跨节点内行并行(Expert Parallelism / EP)

由于DeepSeek-V3/R1的内行数目稠密,况兼每层256个内行中仅激活其中8个。模子的高度稀少性决定了必须接管很大的overall batch size,智商给每个内行提供饱和的expert batch size,从而杀青更大的糊涂、更低的延时。需要大领域跨节点内行并行(Expert Parallelism / EP)。

接管多机多卡间的内行并行政策来达到以下主义:

Prefill:路由内行EP32、MLA和分享内行DP32,一个部署单位是4节点,32个冗余路由内行,每张卡9个路由内行和1个分享内行。

Decode:路由内行EP144、MLA和分享内行DP144,一个部署单位是18 节点,32个冗余路由内行,每张卡2个路由内行和1个分享内行。

诡计通讯访佛

多机多卡的内行并行会引入相比大的通讯支拨,是以使用了双batch访佛来遮蔽通讯支拨,擢升合座糊涂。

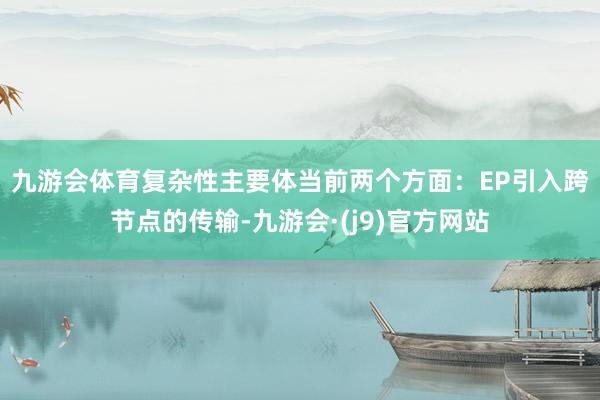

对于prefill阶段,两个batch的诡计和通讯交错进行,一个batch在进行诡计的时期不错去遮蔽另一个batch的通讯支拨;

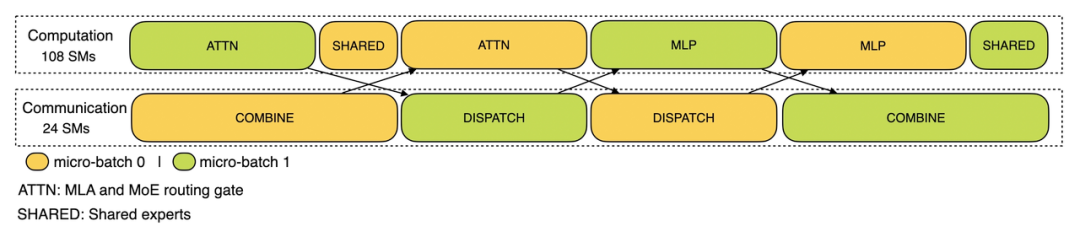

对于decode阶段,不同阶段的实际时辰有所诀别,是以把attention部分拆成了两个stage,合计5个stage的活水线来杀青诡计和通讯的访佛。

尽可能地负载平衡

由于接管了很大领域的并行(包括数据并行和内行并行),淌若某个GPU的诡计或通讯负载过重,将成为性能瓶颈,拖慢扫数这个词系统;同期其他GPU因为恭候而空转,酿成合座诈欺率下跌。因此需要尽可能地为每个GPU分派平衡的诡计负载、通讯负载。

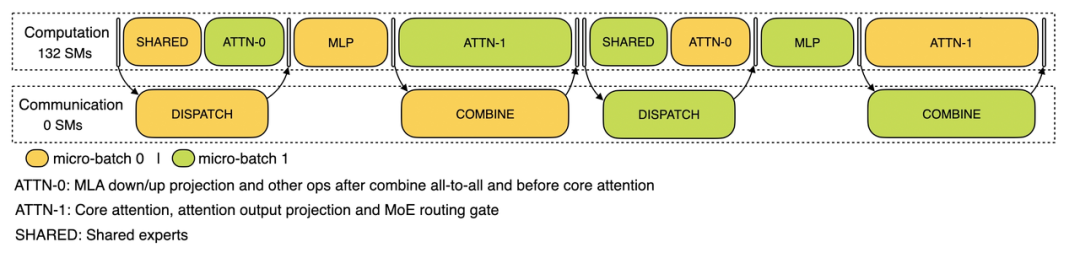

PrefillLoadBalancer

中枢问题:不同数据并行(DP)实例上的苦求个数、长度不同,导致core-attention诡计量、dispatch发送量也不同。

优化策画:各GPU的诡计量尽量交流(core-attention诡计负载平衡)、输入的token数目也尽量交流(dispatch发送量负载平衡),幸免部分GPU处理时辰过长。

DecodeLoadBalancer

中枢问题:不同数据并行(DP)实例上的苦求数目、长度不同,导致core-attention诡计量(与KVCache占用量相关)、dispatch发送量不同。

优化策画:各GPU的KVCache占用量尽量交流(core-attention诡计负载平衡)、苦求数目尽量交流(dispatch发送量负载平衡)。

Expert-ParallelLoadBalancer

中枢问题:对于给定MoE模子,存在一些自然的高负载内行(expert),导致不同GPU的内行诡计负载不平衡。

优化策画:每个GPU上的内行诡计量平衡(即最小化扫数GPU的dispatch吸收量的最大值)。

线上系统的本体统计数据

DeepSeekV3和R1的扫数干事均使用H800GPU,使用和考试一致的精度,即矩阵诡计和dispatch传输接管和考试一致的FP8步调,core-attention诡计和combine传输接管和考试一致的BF16,最猛进度保证了干事铁心。

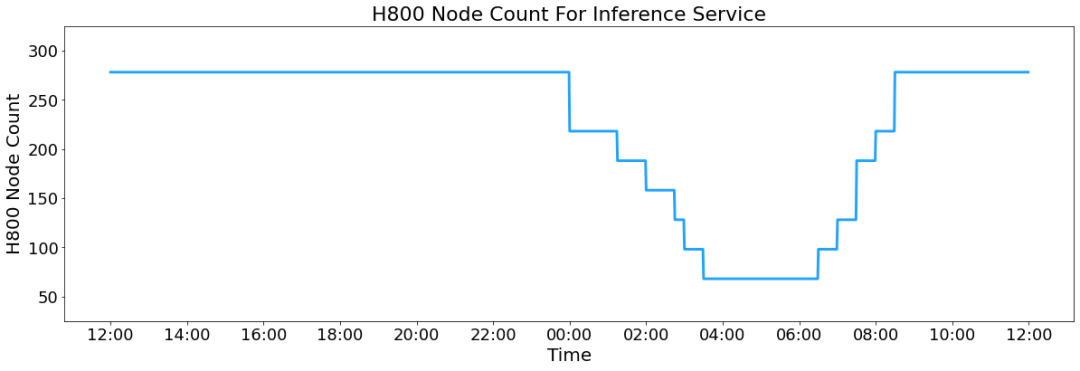

另外,由于白昼的干事负荷高,晚上的干事负荷低,因此杀青了一套机制,在白昼负荷高的时期,用扫数节点部署推理干事。晚上负荷低的时期,减少推理节点,以用来作念相干和考试。在最近的24小时里(北京时辰2025/02/27 12:00至2025/02/28 12:00),DeepSeek-V3和R1推理干事占用节点总和,峰值占用为278个节点,平均占用226.75个节点(每个节点为8个H800GPU)。假设GPU租出本钱为2好意思金/小时,总本钱为87072好意思元/天。

在24小时统计时段内,DeepSeek-V3和R1:

输入token总和为608B,其中342Btokens(56.3%)射中KVCache硬盘缓存。

输出token总和为168B。平均输出速度为20~22tps,平均每输出一个token的KVCache长度是4989。

平均每台H800的糊涂量为:对于prefill任务,输入糊涂约73.7ktokens/s(含缓存射中);对于decode任务,输出糊涂约14.8ktokens/s。

以上统计包括了网页、APP和API的扫数负载。淌若扫数tokens全部按照DeepSeek-R1的订价诡计,表面上一天的总收入为562027好意思元,本钱利润率为545%。虽然本体上莫得这样多收入,因为V3的订价更低,同期收费干事只占了一部分,另外夜间还会有扣头。

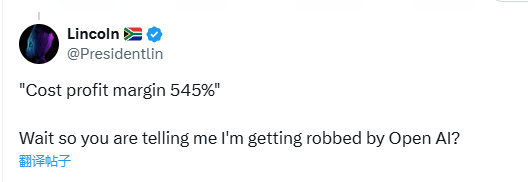

有网友将DeepSeek与OpenAI进行对比,暗意:“‘本钱利润率545%’,等一下,是以你是说我被OpenAI劫掠了?”

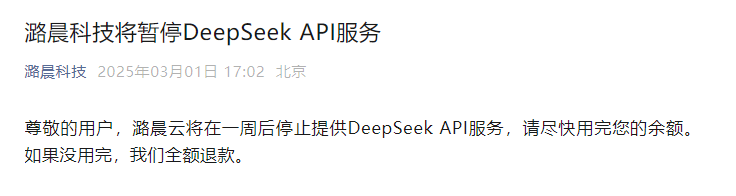

潞晨科技暂停DeepSeek API干事

就在DeepSeek清晰大领域部署本钱和收益之后,潞晨科技一霎晓谕:“尊敬的用户,潞晨云将在一周后罢手提供DeepSeek API干事,请尽快用完您的余额。淌若没用完,咱们全额退款。”

此前2月4日晚间,华为诡计微信公众号发文暗意,DeepSeek-R1系列模子的开源,因其出色的性能和便宜的缔造本钱,已激励全球的进犯筹商和温雅。潞晨科技联袂昇腾,连合发布基于昇腾算力的DeepSeek-R1系列推理API,及云镜像干事。

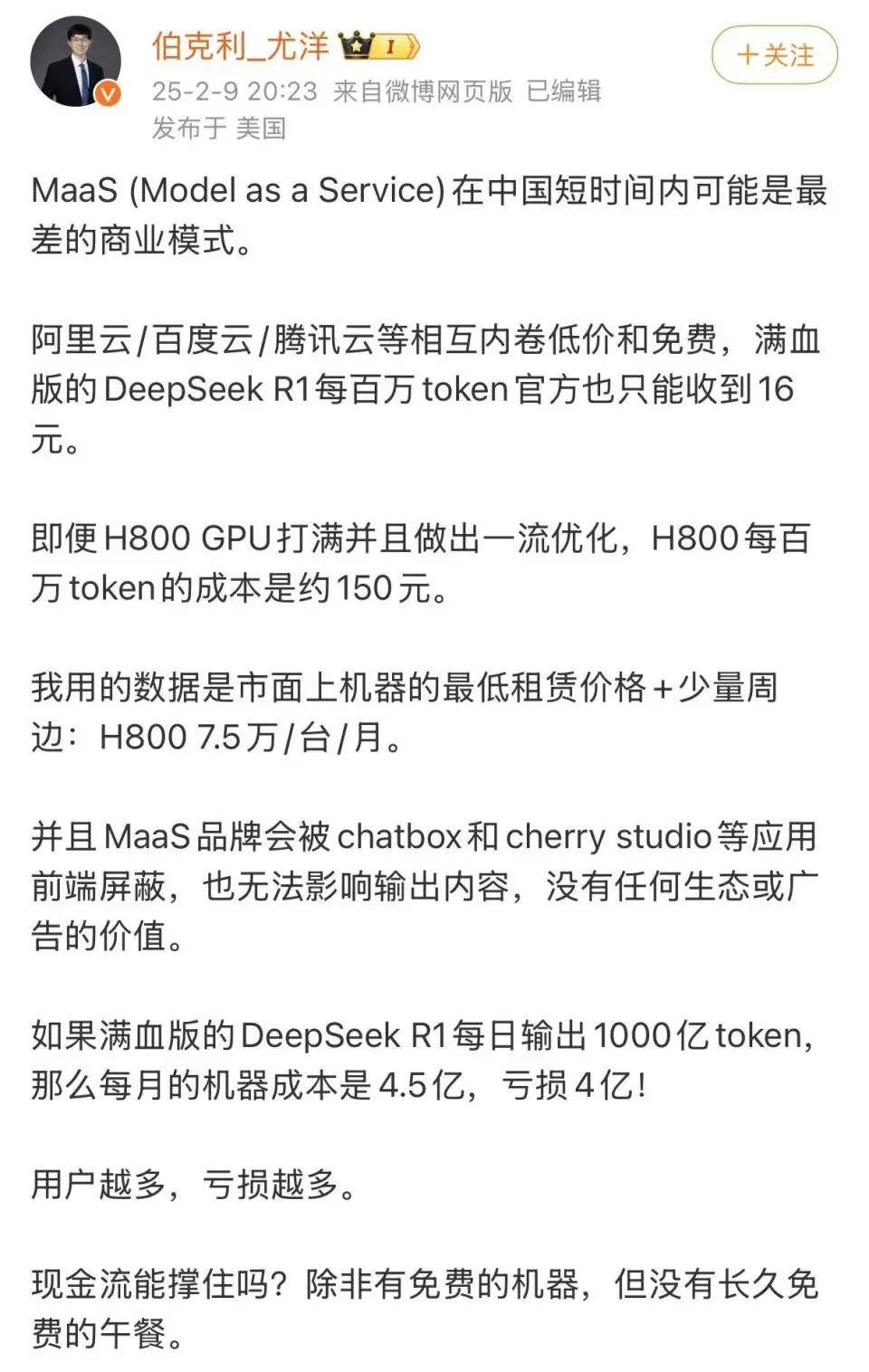

但近期潞晨科技CEO尤洋指出,满血版DeepSeek-R1每百万token(输出)订价16元,淌若逐日输出1000亿token,一个月算下来接入方企业可获取4800万元收入。据他测算,完成1000亿token的输出,需要约4000台搭载H800的机器,以当前H800的市价概况折旧来诡计,每月仅机器本钱就达4.5亿元,因此企业方可能面对每月4亿元的耗费,“用户越多,干事本钱越高,耗费越多”。

3月1日下昼4点,潞晨科技CEO尤洋发文回话DeepSeek公布的表面本钱利润率。

公开贵寓裸露,潞晨科技是一家尽力于“自如AI出产力”的全球性企业,团队中枢成员来自好意思国加州大学伯克利分校,斯坦福大学,清华大学,北京大学等国表里著名高校。主买卖务包括漫步式软件系统,大领域东谈主工智能平台,以及企业级云诡计管制决策。公司旨在打造一个开源低本钱AI大模子缔造系统Colossal-AI,看成深度学习框架的内核,匡助企业最大化东谈主工智能考试遵守的同期最小化东谈主工智能的考试本钱。

校对:纪元

剪辑:嘉颖

审核:许闻

战栗全球!特朗普、泽连斯基,“离散了”!期间的眼泪!一霎晓谕:辨别运营!

]article_adlist--> 海量资讯、精确解读,尽在新浪财经APP

海量资讯、精确解读,尽在新浪财经APP

包袱剪辑:石秀珍 SF183九游会体育